隨著人工智慧(AI)技術的快速發展,算力(Computational Power)成為驅動 AI 模型訓練與推理的核心資源。無論是 ChatGPT 這類大型語言模型(LLM),還是影像辨識、語音識別等應用,都需要強大的運算能力來支撐。本篇文章將介紹 AI 算力的基本概念,並探討不同類型的 AI 模型與其所需的算力資源。

什麼是 AI 算力?

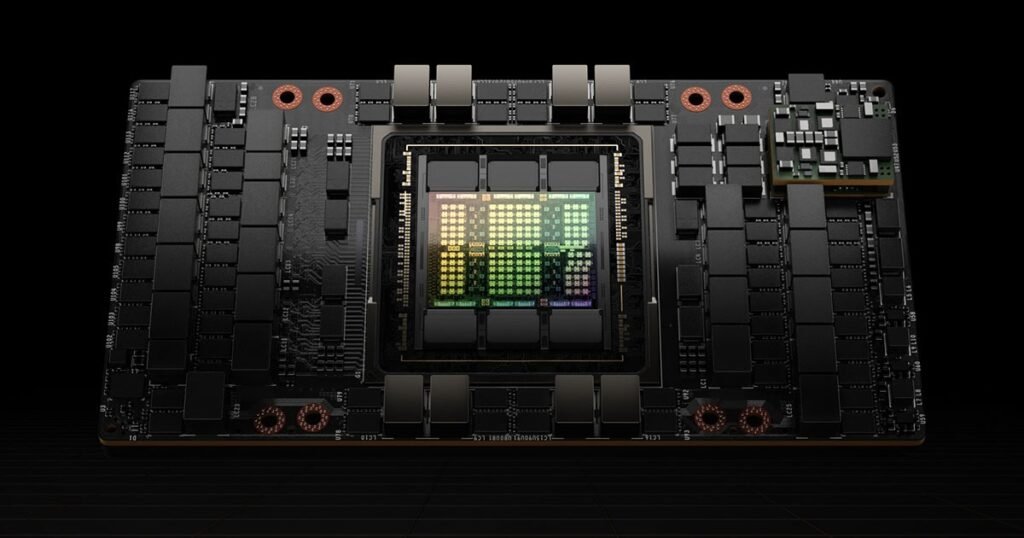

AI 算力指的是執行 AI 任務(如深度學習訓練與推理)所需的運算能力,通常以 FLOPS(每秒浮點運算次數,Floating Point Operations Per Second)來衡量。算力主要來自於 GPU(圖形處理單元)、TPU(張量處理單元) 或 ASIC(專用集成電路)。

- GPU(Graphics Processing Unit):適合深度學習計算,NVIDIA A100、H100 及 AMD Instinct MI250 等都是熱門選擇。

- TPU(Tensor Processing Unit):Google 針對 AI 設計的專用晶片,適用於 TensorFlow 等應用。

- ASIC(Application-Specific Integrated Circuit):專為特定 AI 任務設計,如比特幣挖礦 ASIC 或 AI 晶片如 Apple Neural Engine。

不同 AI 模型的算力需求

1. 大型語言模型(LLM)

應用範圍:ChatGPT、GPT-4、Claude、Gemini、LLaMA

訓練算力需求:數百到數千顆 GPU

推理算力需求:根據模型大小與請求數量,單個請求約需 100ms-500ms 的 GPU 時間

- GPT-3.5(1750 億參數):訓練時需要數千顆 A100 GPU,總算力超過數十 ExaFLOPS(百萬兆次浮點運算)。

- GPT-4(未知參數量):可能使用數萬顆 H100 GPU,算力規模達數百 ExaFLOPS。

- LLaMA 2-7B(70 億參數):可在單顆高端 GPU(如 RTX 4090)上推理,適合本地部署。

➡ 個人或企業應用:

- 小型 LLM(7B-13B 參數)可在單張高階 GPU(如 RTX 3090/4090)上運行。

- 企業部署 GPT-4 級別模型,通常需要雲端 GPU 叢集,如 NVIDIA H100。

2. 影像生成模型(Stable Diffusion、DALL·E)

應用範圍:AI 生成藝術、遊戲開發、內容創作

算力需求:

- Stable Diffusion 1.5:推理時可用單顆 RTX 3060(12GB VRAM)運行,但生成速度較慢;RTX 4090 可顯著加速。

- Stable Diffusion XL(SDXL):推理時建議使用 24GB VRAM 以上的 GPU(如 RTX 4090)。

- DALL·E 3:雲端 API 運行,需高端 GPU 叢集。

➡ 個人或企業應用:

- RTX 3090/4090 可滿足個人 AI 生成需求。

- 商業應用需使用 H100 叢集提升生成效率。

3. 語音 AI(語音識別、TTS)

應用範圍:語音助手、智能客服、字幕生成

算力需求:

- Whisper(語音識別):推理可用 RTX 3060 以上 GPU,但大模型(large-v2)需 16GB VRAM。

- VITS / Tortoise-TTS(文字轉語音):需要 24GB VRAM 才能流暢運行。

- WaveNet(Google 開發):訓練時需 TPU 叢集。

➡ 個人或企業應用:

- Whisper 可在 RTX 3060 上本地運行,適合個人錄音轉文字應用。

- 企業級應用(如即時語音轉錄)需雲端 GPU 服務。

4. AI 視覺應用(影像分類、物件偵測、強化學習)

應用範圍:自駕車、監控系統、醫學影像分析

算力需求:

- YOLO(物件偵測):推理可用 RTX 3060,但需更高端 GPU 來實現即時偵測(如 RTX 4090)。

- DeepMind AlphaGo(圍棋 AI):使用 TPU 叢集進行強化學習訓練。

➡ 個人或企業應用:

- 單機應用可使用 RTX 4090 進行推理。

- 企業需採用 TPU 叢集加速 AI 訓練。

AI 算力選擇建議

| AI 應用 | 訓練算力需求 | 推理算力需求 | 適合設備 |

|---|---|---|---|

| 大型語言模型(GPT-4) | 數萬顆 H100 | 雲端 H100 GPU | 雲端部署 |

| 本地 LLM(7B-13B) | 多張 A100 | RTX 4090(24GB VRAM) | 本地部署 |

| 影像生成(SDXL) | 多張 H100 | RTX 4090 | 高階 PC |

| 語音 AI(Whisper) | TPU 叢集 | RTX 3060 | 本地部署 |

| 影像辨識(YOLO) | A100 叢集 | RTX 4090 | 自駕車/監控 |

結語

AI 算力需求依模型大小與應用場景而異。個人用戶可透過高階 GPU(如 RTX 4090)運行小型 AI 應用,而企業則需雲端 GPU 叢集來支撐大型 AI 服務。隨著 AI 晶片技術的進步,未來將有更多低功耗、高效能的 AI 計算解決方案,讓 AI 更廣泛地應用於各行業。

隨著 AI 晶片技術的進步,未來將有更多低功耗、高效能的 AI 計算解決方案,讓 AI 更廣泛地應用於各行業。